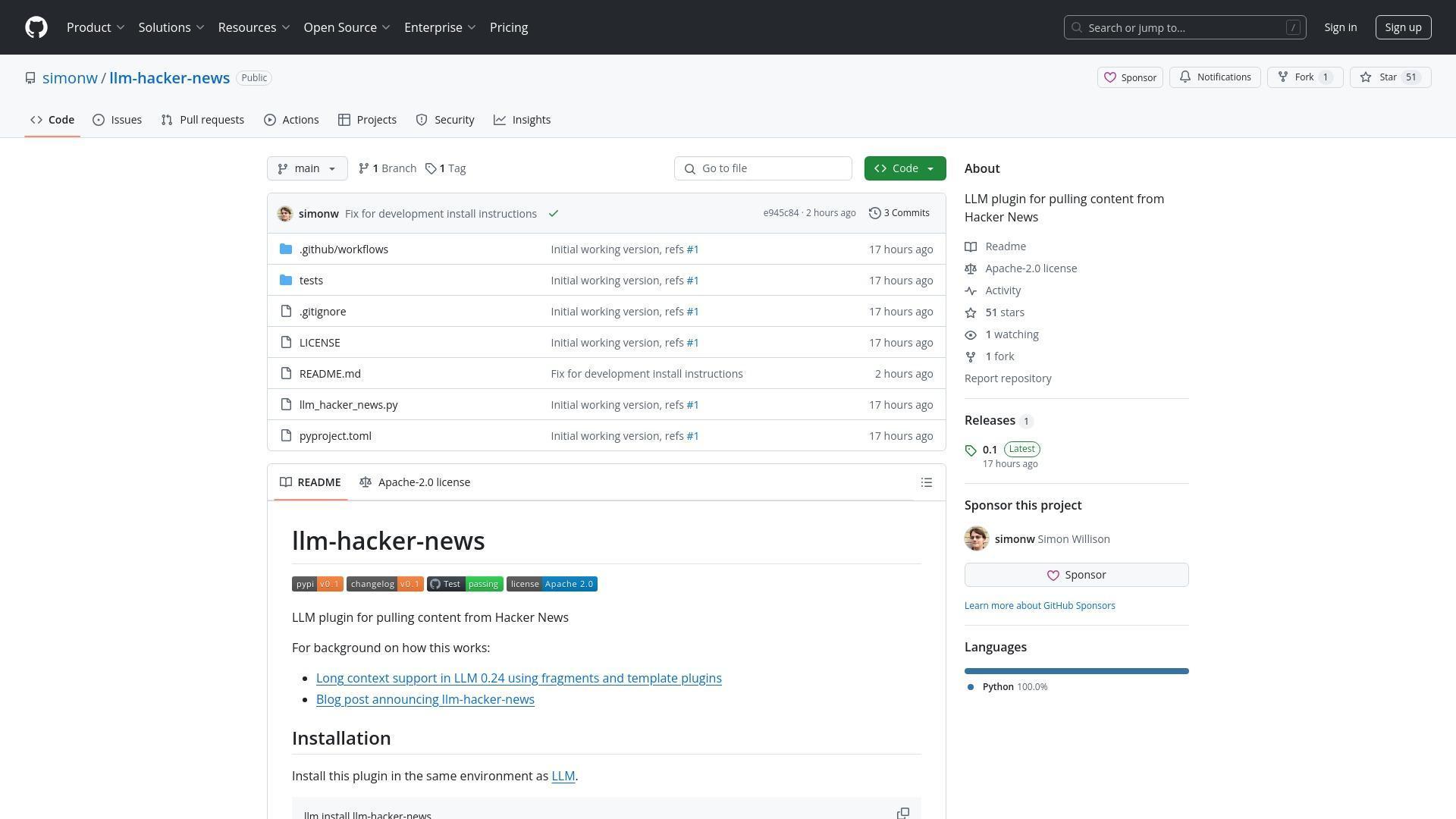

Simon Willison 最近為他的命令列 LLM 工具釋出了一個名為 llm-hacker-news 的新外掛,該外掛旨在從 Hacker News 討論中提取內容並直接輸送給大型語言模型。雖然這一技術成就給許多人留下了深刻印象,但它也引發了關於資料隱私、同意和使用公共論壇內容進行人工智慧處理的倫理道德的重大爭論。

技術創新

llm-hacker-news 外掛建立在 Willison 為其 LLM 命令列工具新增的 fragments 功能之上。這一功能允許使用者輕鬆地將長上下文內容輸入到 Gemini 和 Llama 4 等大型語言模型中。該外掛特別使使用者能夠使用簡單的命令語法檢索整個 Hacker News 討論執行緒:

llm -f hn:43615912 'summary with illustrative direct quotes'

該外掛從 Hacker News API 獲取資料,將其轉換為對 LLM 友好的文字格式,然後將其傳送到使用者配置的預設模型(如 gpt-4o-mini)。這簡化了分析和總結線上討論的過程,無需手動複製和貼上。

llm-hacker-news 外掛的主要特點:

- 允許使用專案 ID 獲取完整的 Hacker News 討論帖

- 基於 LLM 命令列工具中的新"fragments"功能構建

- 使用 Algolia JSON API 檢索內容

- 將 HN 內容轉換為對 LLM 友好的文字格式

- 適用於各種 LLM 模型,包括 GPT-4o-mini、Claude 和 Gemini

安裝和使用方法:

llm install llm-hacker-news

llm -f hn:43615912 'summary with illustrative direct quotes'

相關社群關注點:

- 資料隱私和內容處理同意問題

- 服務條款合規性

- 人類閱讀與演算法處理的區別

- AI 驅動的網際網路環境下內容所有權的未來

隱私擔憂和同意問題

該外掛的釋出引發了一場激烈的討論,關於使用者是否應該能夠選擇退出讓他們的論壇帖子被 LLM 處理。一位使用者直接詢問:是否有辦法選擇退出讓我的對話被輸入到 LLM 中?這個問題反映了人們對內容抓取和使用權的日益關注。

「人們擔心的是,LLM 寄生蟲正在浪費他們的頻寬,從而浪費他們的金錢,以便從他人的工作中獲利。」

Willison 回應指出,防止複製貼上操作在實際上是不可能的,他指出即使存在此類限制,截圖也可以規避它們。他還強調了 LLM 訓練政策的複雜格局,其中像 OpenAI 和 Anthropic 這樣的提供商不會用 API 提交的內容進行訓練,而像 Gemini 這樣的提供商可能會使用免費層使用者的資料來改進產品。

法律和倫理邊界

幾位評論者提出了關於該外掛是否違反 Hacker News 服務條款的問題,該條款禁止抓取和資料收集。一位使用者特別引用了 HN 指南:除非 Y Combinator 明確授權,否則您同意不修改、複製、框架、抓取、[...]或基於網站或網站內容建立衍生作品。

討論揭示了公共可訪問性和內容所有權之間的基本張力。雖然有些人認為在公共論壇上發帖隱含著對各種形式消費的同意,但其他人則認為人類閱讀和演算法處理之間存在有意義的區別,特別是當這種處理最終可能會進入商業 AI 訓練資料集時。

LLM 工具的未來

儘管存在爭議,許多使用者對該技術的潛力表示了興趣。擴充套件功能的請求包括總結 HN 上的熱門話題、跟蹤隨時間推移的討論,以及與其他協議(如 MCP,訊息上下文協議)整合。Willison 提到他的下一個重大 LLM 功能將是工具支援,計劃在該框架之上構建 MCP 外掛。

討論還涉及了本地 LLM 模型質量的快速提升。Willison 指出,直到大約六個月前,本地模型大多無法使用,但最近變得更加強大,像 Qwen Coder 2.5、Llama 3.3 70B、Mistral Small 3 和 Gemma 3 等模型現在在具有足夠 RAM 的消費級硬體上表現令人印象深刻。

llm-hacker-news 外掛既代表了令人興奮的技術可能性,也代表了隨著 AI 工具更加融入我們的線上體驗而產生的複雜倫理問題。隨著這些技術的不斷發展,社群需要在創新與尊重使用者代理和內容權利之間取得平衡。