為機器學習開發的專業 OCR(光學字元識別)系統引發了關於 AI 可靠性、資料完整性和倫理考量的重要討論。最近分享的一個專為從複雜教育材料中提取結構化資料而設計的 OCR 系統,成為了社群關於在文件處理流程中使用生成式 AI 的利弊的深入討論中心。

|

|---|

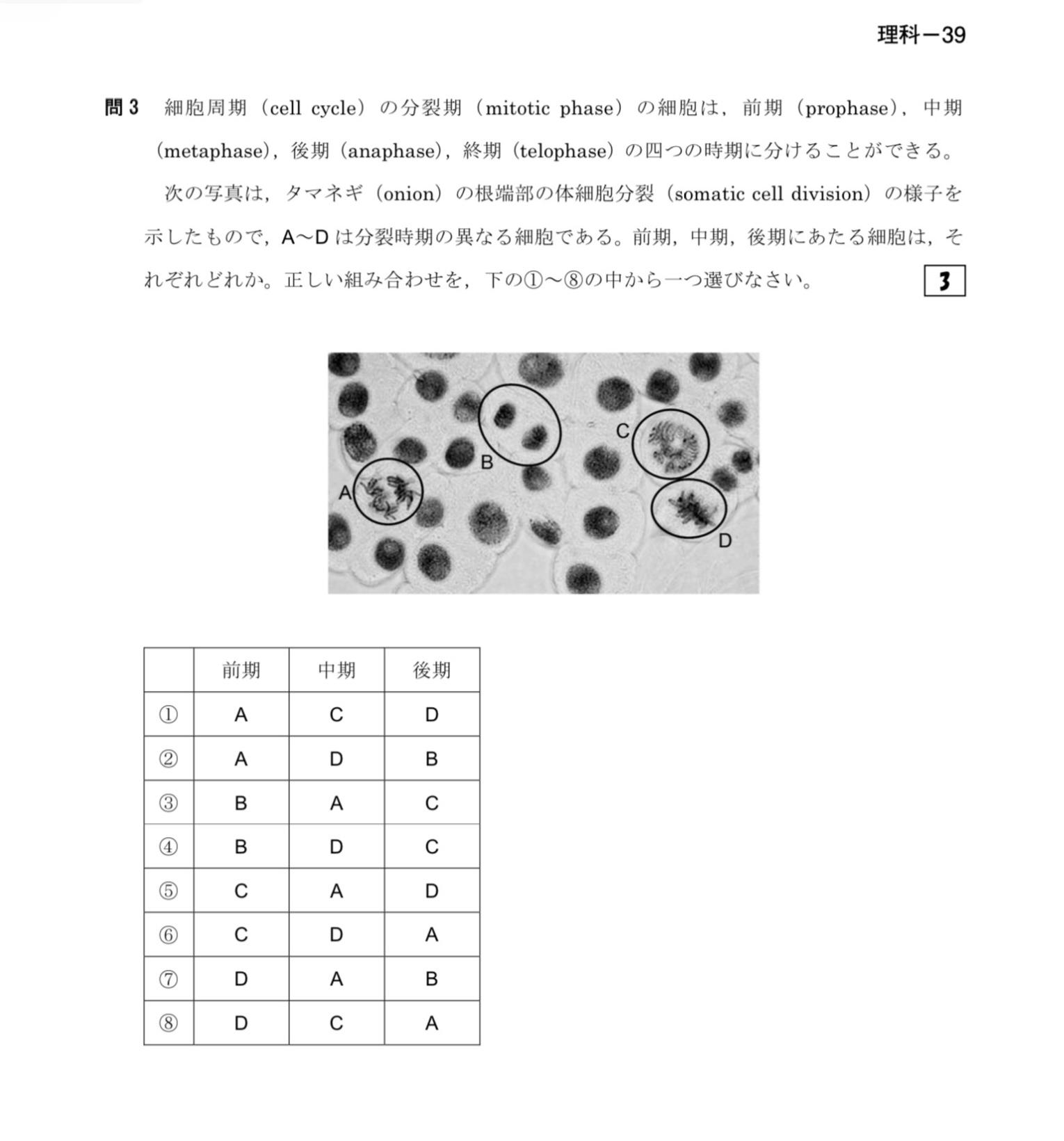

| 這幅插圖解釋了植物細胞有絲分裂的各個階段,強調了在教育材料中結構化資料提取的重要性 |

AI 增強型 OCR 的幻覺問題

社群成員對在 OCR 過程中使用大型語言模型(LLMs)的可靠性提出了重大擔憂。主要的擔憂集中在 AI 幻覺上——模型可能不僅會修復真正的 OCR 錯誤,還可能無意中改變正確的內容或生成完全虛構的資訊。一位評論者將這種風險比作增強版的施樂錯誤,指的是歷史上掃描文件時數字被意外替換的問題,但當 AI 參與其中時,可能會帶來更嚴重的後果。

開發者承認了這些擔憂,並指出他們實施了兩階段方法,其中傳統 OCR 引擎負責初始文字提取,生成式 AI 僅在第二階段的最佳化中應用。他們還提到實施了簡單的驗證檢查,以防止更改正確提取的文字,儘管這些保障措施的有效性仍有待徹底評估。

OCR系統的關鍵元件

- DocLayout-YOLO:用於表格區域檢測

- Google Vision API:用於表格處理和影像分析

- Gemini Pro Vision:用於生成上下文感知描述

- MathPix OCR:用於數學公式提取

- OpenCV:用於影像處理

主要社群關注問題

- 使用LLMs進行OCR時的AI幻覺風險

- 提示注入漏洞

- 許可證衝突(MIT與AGPL-3.0)

- 訓練資料的道德獲取

- AI輔助通訊的真實性

計劃的未來改進

- 支援完全本地推理,無API依賴

- 替代開源元件:

- Tesseract或TrOCR用於通用OCR

- Pix2Struct、Donut或DocTR用於文件結構

- OpenAI CLIP用於影像-文字語義對齊

- Gemma / Phi / LLaMA / Mistral用於推理任務

- 增強語義結構化模組

提示注入漏洞

關注安全的評論者強調提示注入是另一個潛在風險領域。由於 LLMs 作為處理流程的一部分,在保持指令與被處理資料之間的清晰分離方面存在固有挑戰。這可能使文件中的惡意內容有機會操縱系統行為。

開發者回應說,他們正嘗試透過使用 JSON 格式來分離指令和資料,並在沙盒環境中執行系統來緩解這一風險。然而,他們承認這種方法並不完美,表明安全問題仍是需要持續改進的領域。

開源和許可問題

該專案的許可結構也受到了審視。雖然最初是在 MIT 許可下發布的,但社群成員指出了與一些整合元件的潛在不相容性——特別是使用更嚴格的 AGPL-3.0 許可的 DocLayout-YOLO 模型。這凸顯了 AI 混合系統必須面對的複雜許可環境,尤其是當結合具有不同要求的多個開源元件時。

開發者對這一許可衝突表示驚訝,迅速承認了這一疏忽,並承諾更仔細地審查許可要求——這展示了開發者在正確管理 AI 系統開發的法律方面所面臨的挑戰。

語言翻譯和溝通挑戰

圍繞開發者使用 LLMs 幫助撰寫對社群評論的回應,產生了一個有趣的元討論。當被質疑其異常流暢的寫作風格時,開發者透露他是一名 19 歲的韓國學生,使用 AI 輔助以便更清晰地用英語交流。這引發了關於使用 AI 作為溝通輔助工具與保持真實個人表達之間合法性的更廣泛討論。

一些社群成員為這種用例辯護,認為這完全合理——將其比作使用鍵盤或拼寫檢查器來增強交流——而其他人則對透過 AI 中介通訊導致的線上話語日益同質化表示擔憂。

OCR 在機器學習中的未來方向

儘管存在擔憂,許多評論者認可了該專案的核心目標:透過從複雜文件中提取結構化資訊來提高機器學習訓練資料的質量。一位評論者強調,將提取的資料組織成一個連貫的、語義上有意義的結構對於高質量的機器學習訓練至關重要,這表明超越基本佈局分析的語義結構化代表了在機器學習訓練流程中最大化 OCR 資料價值的下一個前沿。

開發者表示計劃向這個方向擴充套件系統功能,新增用於構建層次表示和識別跨文件部分的實體關係的模組。

隨著 AI 繼續被整合到文件處理工作流程中,圍繞這個 OCR 系統的社群討論突顯了開發者必須在利用 AI 能力與解決關於資料完整性、安全性和倫理使用的合法擔憂之間取得的微妙平衡。這一對話表明,開放分享 AI 工具可以帶來有價值的社群反饋,最終為所有人改進技術。

參考:為機器學習最佳化的 OCR 系統:圖形、圖表、表格、數學和多語言文字

|

|---|

| 結構化的視覺資料表示對於提高機器學習訓練資料的質量至關重要 |